Note

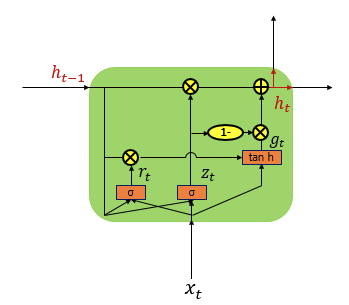

게이트 순환 유닛(Gated Recurrent Unit, GRU) 본문

728x90

GRU는 LSTM의 장기 의존성 문제에 대한 해결책을 유지하면서, 은닉 상태를 업데이트하는 계산을 줄였습니다.

GRU는 성능은 LSTM과 유사하면서 복잡했던 LSTM의 구조를 단순화 했다.

'Deep Learning' 카테고리의 다른 글

| LSTM 이해하기 (0) | 2022.05.22 |

|---|---|

| Simple RNN 이해하기 (0) | 2022.05.21 |

| 장단기 메모리(Long Short-Term Memory, LSTM) (0) | 2022.05.18 |

| 순환 신경망(Recurrent Neural Network, RNN) (0) | 2022.05.17 |

Comments